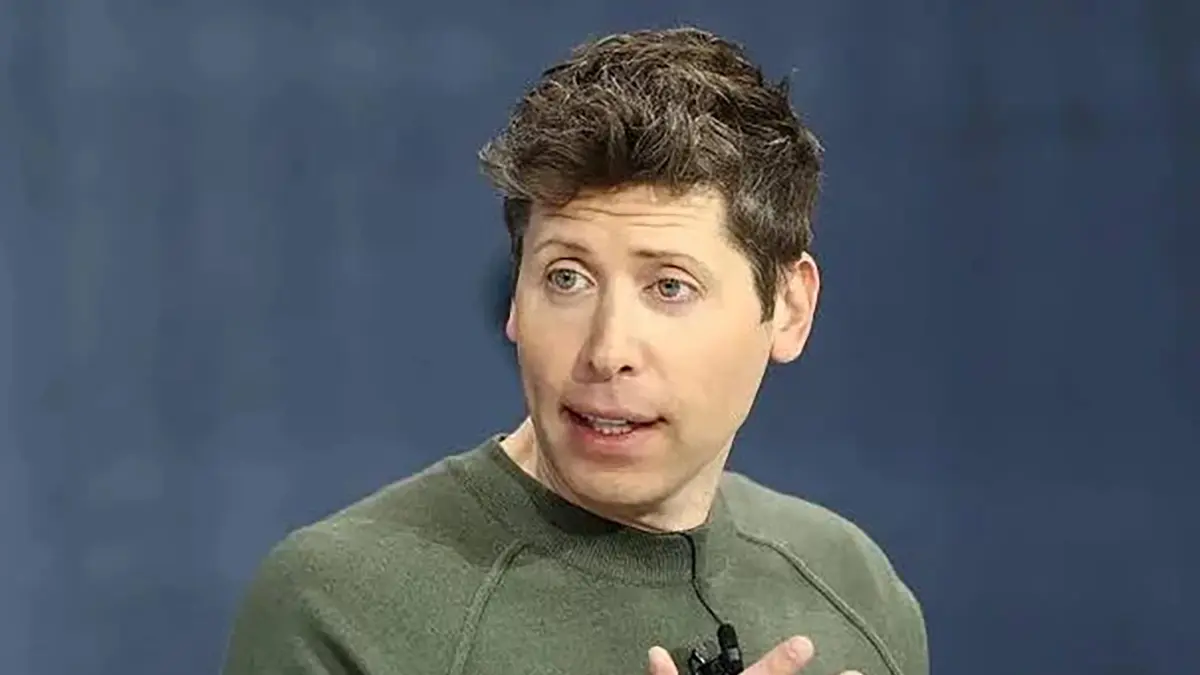

Sam Altman (OpenAI) i el costat insomne de la IA: què hi ha darrere del “no dormo bé” de ChatGPT

Un cafè amb gel, dues mirades al mòbil i el timeline ple de IA i profecies. A l’AP-7, entre retencions i podcasts sobre ètica, el tema torna: qui decideix què pot fer una màquina que ja opina de tot?

Enmig del soroll, hi ha una frase que pesa més que un diesel al port de l’IKEA. El cap d’OpenAI admet que hi ha nits llargues. Però el per què —i què implica per ChatGPT— no és tan obvi com sembla.

- OpenAI, ChatGPT i el debat que no s’acaba

- El paper dels límits: entre Musk, YouTube i la realitat

- Taula ràpida: llibertat d’usuari vs. seguretat

- Per què ens hauria d’importar (més enllà del titular)

OpenAI, ChatGPT i el debat que no s’acaba

Últimament vivim en un bucle de titulars sobre IA, promeses i apocalipsis a parts iguals. Entre la N-340 i els semàfors, la conversa és sempre la mateixa: qui posa els límits, com s’apliquen i quan coneixerem la factura real d’aquesta tecnologia. Els models parlen, però algú n’és responsable; i sí, això pesa.

El tema moral no és nou, però ara aterra amb olor de circuit imprès i responsabilitat. Es discuteix la singularitat, es juguen partides de transhumanisme i es barregen metàfores de laboratori amb la realitat d’un xat que consultem per tot. Fins aquí, cap sorpresa. Però hi ha un detall que ha encès els fars curts i els llargs alhora.

El CEO d’OpenAI, Sam Altman, ha explicat que no dorm bé des del llançament de ChatGPT. No és postureig d’emprenedor; és el símptoma d’una càrrega moral i operativa que es mesura en milions d’interaccions diàries i en decisions petites amb impacte enorme sobre com es comporta el model.

Què hi ha darrere del “no dormo bé”

Altman admet que el model respon sota un marc moral treballat amb centenars d’experts, però que la decisió final “és nostra”. Traduit de l’argot tech: consultar a filòsofs i responsables d’ètica està molt bé, però algú prem el botó i signa la responsabilitat. Segons ell, el que més l’inquieta no són les “grans decisions” —on hi ha consens— sinó les mil petites triaades que defineixen com el model actua.

La tensió és clara: vols llibertat d’usuari i alhora seguretat. Vols utilitat i no vols ensenyar a fer una arma biològica. En paraules d’Altman, cal equilibrar l’“espai adult per a usuaris adults” amb un marc que no normalitzi riscos. I això, cada dia, a cada prompt, a cada país.

Com es prenen les decisions (i per què et toquen)

Un principi que es repeteix a OpenAI és respectar les lleis locals i reflectir “l’agregat moral” de la base d’usuaris. És a dir: no imposar una moral privada, sinó ajustar el model a estàndards socials canviants. “Som facilitadors”, ve a dir. Un investigador d’ètica tecnològica consultat recorda que “els models no són neutrals; la neutralitat és una decisió dissenyada” (opinió recollida a tall d’anàlisi, 2025).

Al capdavall, qui mana? Hi ha un equip de comportament del model, consultes a experts, i una cara visible que assumeix la responsabilitat pública. O com deia un enginyer sènior d’una gran tecnològica el 31/10/2025: “La IA és una eina, però les conseqüències no són virtuals: afecten educació, salut i feina”.

El paper dels límits: entre Musk, YouTube i la realitat

- Llançament: ChatGPT es popularitza el novembre de 2022.

- Responsable: Sam Altman, CEO d’OpenAI.

- Eix de debat: llibertat vs. seguretat a escala global.

- Marc: consultes a experts en ètica + decisions internes.

En l’entrevista recent, Altman també aborda friccions amb Elon Musk i l’horitzó de la IA capaç de fer descobriments científics en pocs anys. No és rumorologia: és la confirmació que el sector corre mentre el marc normatiu camina. I aquí és on el soroll del debat es converteix en decisions de producte.

Per cert, el vídeo on es despleguen aquests temes s’ha difós a YouTube i mitjans generalistes. Si vols el context, consulta la informació oficial d’OpenAI i compara el relat públic amb el que diu l’empresa sobre seguretat i usos responsables. El contrast és útil per separar show i full de ruta.

Com s’entrena la moral d’un model

Hi ha una metàfora útil que circula entre experts: eduquem la IA com criatures, però a escala. No n’hi ha una, sinó centenars de milers de versions que s’avaluen en paral·lel. El procés és reconeixement de patrons, recompensa o correcció i selecció dels sistemes que millor alineen resposta i objectius. La part freda? Les que no serveixen, es descarten amb la mateixa rapidesa amb què carregues el carretó a l’IKEA i abandones el marc que no toca.

Això explica per què una petita decisió —com respondre a una pregunta sensible— pot tenir un gran efecte en l’experiència de milions d’usuaris. I per què el “no dormo bé” no és drama: és governança del risc.

Taula ràpida: llibertat d’usuari vs. seguretat

| Àrea | Risc percebut | Criteri d’actuació |

|---|---|---|

| Biologia/Armes | Altíssim: ús maliciós immediat | Restringir: no instruccions operatives |

| Salut | Mitjà-alt: impacte real en decisions | Avisos + derivar a professionals |

| Educació | Mitjà: plagi/enganxalls | Promoure aprendre vs. copiar |

| Política | Alt: desinformació i polarització | Regles clares + equilibri de fonts |

Veus i contrapesos

Al llarg de l’entrevista, Altman juga a una cosa poc sexy però essencial: explicar límits. “No és el meu paper decidir la moral”, ve a dir; “reflectim el promig de preferències humanes dins les lleis de cada lloc”. Una analista de polítiques públiques consultada el 31/10/2025 resumeix: “Si la IA és infraestructura, necessita governança com les carreteres: normes, senyals i multes” (opinió indirecta).

Això connecta amb el mercat: quan el model genera confiança, el cost regulatori baixa; quan hi ha incidents, pugen els cons a l’asfalt i s’alenteix el trànsit. Els que van al volant —OpenAI, competidors i reguladors— saben que no hi ha GPS infal·lible.

Per què ens hauria d’importar (més enllà del titular)

La següent capa és de carrer: educació, feina i serveis ja incorporen IA. El que avui és un prompt, demà és un procés. Les decisions petites que preocupen Altman es tornen macro quan el teu banc, el teu metge o el teu ajuntament integren automatitzacions. Per això convé entendre qui decideix què i amb quins frens.

En una Europa que regula amb la IA Act a l’horitzó, el relat d’OpenAI es trobarà amb normes concretes. I el “no dormo bé” potser és la millor campanada d’alarma: tant per a l’empresa que construeix el producte com per a usuaris, premsa i reguladors que l’han d’avaluar sense mites ni pànics.

El resum en tres punts (sense drama)

- El pes és real: decisions “petites” modelen el comportament a escala.

- Llibertat vs. seguretat: l’equilibri no és teòric; és diari i local.

- Governança: més enllà del CEO, calen processos i transparència.

Al final, entre una sortida 12 de l’AP-7 i un cafè massa llarg, queda clar que el cas Sam Altman–OpenAI–ChatGPT no va de geni insomne sinó de sistemes. I que la pregunta correcta no és “dorms?” sinó “com preneu decisions i qui n’és responsable?”. És aquí on la IA deixa de ser eslògan i es converteix en infraestructura adulta.